Il MUFOCO – Museo di Fotografia Contemporanea di Cinisello Balsamo ospita ANIMATI. God, Human, Animal, Machine, una mostra che interroga l’umanità attraverso lo sguardo di una macchina. Curata da Chiara Bardelli Nonino, con il contributo di Emanuele Amighetti e Giacomo Mercuriali, ANIMATI è il primo progetto in Italia a esplorare un archivio fotografico pubblico tramite intelligenza artificiale, aprendo un dialogo inedito tra visione algoritmica e sensibilità artistica. Come sottolinea il presidente del MUFOCO, Davide Rondoni, «la mostra rilancia le domande fondamentali sull’essere umano… e le amplifica». In questa intervista, i tre protagonisti ci guidano dietro le quinte di una curatela aumentata, tra sfide tecnologiche, scelte estetiche e provocazioni etiche.

Sara Benaglia: Comincerei con una domanda a Chiara, curatrice del progetto. Come hai selezionato le parole chiave da cui ha preso avvio la ricerca algoritmica nell’archivio del MUFOCO? Cosa ti ha guidata nella definizione di questo vocabolario curatoriale?

Chiara Bardelli Nonino: Effettivamente trovare le query attorno a cui improntare la ricerca nell’archivio è stata una delle fasi più complicate. La parola chiave da cui tutto è iniziato è “animati”, che è la suggestione data dal presidente Rondoni, assieme alla volontà di immaginare una mostra che valorizzasse l’archivio. La mia prima idea era provare a esplorarlo con uno sguardo etologico, cercando i lavori che raccontassero l’animale uomo nella sua specificità e tensione tra cultura e natura. Ho quindi raccolto una lunga lista di concetti dai fondamenti dell’etologia di Irenäus Eibl-Eibesfeldt. Quando il concept curatoriale è cambiato in quello attuale di ANIMATI, quella lista è diventata il nucleo di partenza della nuova ricerca, ampliato con un’attenzione particolare all’impatto delle nuove tecnologie – le tensioni sottostanti si sono spostate di conseguenza. La guida in questa fase è stata un altro libro, da cui ho preso il sottotitolo: God, Human, Animal, Machine: Technology, Metaphor, and the Search for Meaning di Meghan O’Gieblyn. Un passaggio in particolare mi ha spinto a voler usare l’intelligenza artificiale come primo filtro curatoriale: O’Gieblyn spiega che con l’avanzare della tecnologia, le caratteristiche che avrebbero dovuto differenziare l’umano da tutto il resto – alta cognizione, razionalità, capacità di astrazione – sono paradossalmente proprio quelle in cui le macchine eccellono; quello che fanno molta più fatica a imitare sono le qualità tradizionalmente considerate più animali: quelle sensoriali, percettive, emotive.

SB: Quali ragioni vi hanno portato a scegliere CLIP come strumento per guidare l’esplorazione dell’archivio, rispetto ad altri modelli di intelligenza artificiale disponibili?

Giacomo Mercuriali: CLIP è un modello open source impiegabile gratuitamente da chiunque. Era possibile impiegare altri modelli come quelli di Facebook o Google ma ho deciso di usare CLIP perché è stato il primo di questo genere di modelli a essere reso disponibile gratuitamente e quindi dal punto di vista culturale ha segnato l’epoca. Inoltre, essendo OpenAI una società no profit ritengo moralmente superiore operare con strumenti sviluppati secondo questa filosofia rispetto a strumenti sviluppati con l’obiettivo di generare profitto.

SB: Nel lavorare con un archivio pubblico ma composto da opere coperte da copyright, come avete definito il confine tra accessibilità e utilizzo lecito, anche alla luce delle eccezioni previste per usi di ricerca o sperimentazione artistica?

GM: Le immagini che abbiamo usato sono accessibili online presso Mufocosearch . L’uso che ne abbiamo fatto non è diverso da quello che si può fare studiando i libri in una biblioteca pubblica, magari ricopiando sul proprio quaderno le frasi e i pensieri che si trovano più interessanti per citarli o rielaborarli in seguito.

SB: L’utilizzo di un modello AI come CLIP su un archivio fotografico pubblico può sollevare dubbi legati alla gestione dei diritti d’autore. In che modo avete affrontato questi aspetti tecnici e legali durante il progetto?

GM: Il modello è sviluppato da OpenAI e rilasciato in open access. Avendo lavorato sul mio PC, non ho immesso nessuna immagine protetta in server di proprietà altrui. Piuttosto, questo è quello che facciamo tutti ogni volta che usiamo Gmail o Whatsapp. L’80% dei siti internet (e quindi dei dati che contengono o trafficano) è ospitato da macchine di proprietà di Amazon, Microsoft e Google. Vale davvero la pena accapigliarsi su temi del genere quando le infrastrutture pubbliche (compresi i musei, gli archivi, le soprintendenze…) di tutti gli stati occidentali operano con software e hardware prodotti e mantenuti da imprese statunitensi? Di ciascuna immagine di partenza, l’AI ha “visto” (sarebbe meglio abbandonare l’antropomorfismo quando si discute di questi temi) una rappresentazione (un vettore algebrico rappresentato da stati elettronici, 0 e 1) di una rappresentazione (una immagine digitale, quindi una serie di 0 e 1) di una rappresentazione (la fotografia sviluppata) di una rappresentazione (il negativo fotografico). Per essere corretto, poiché parliamo di reti neurali che comprimono e ricomprimono dati, dovrei spacchettare la prima rappresentazione di questa mia lista scrivere rappresentazione di rappresentazione probabilmente un centinaio di volte.

SB: Nel processo di analisi delle immagini, CLIP tiene conto anche dei nomi dei file o lavora esclusivamente sui contenuti visivi e testuali associati?

GM: I nomi dei file non rientrano nei dati elaborati da CLIP.

SB: Nel dataset usato per l’analisi con CLIP, le immagini avevano solo il codice identificativo e non includevano altri metadati. Hai scelto consapevolmente di non guidare l’AI con informazioni archivistiche o didascaliche. Come mai hai deciso di limitare l’input in questo modo e perché usare solo le 12.000 immagini catalogate scientificamente, se l’archivio digitale ne conta oltre 60.000?

CBN: Le immagini lette da CLIP avevano solo esclusivamente il codice identificativo alfanumerico, per ritrovarle nella fase successiva. Non volevo dare all’AI nessuna informazione ulteriore che ne guidasse i risultati. La scelta di usare le immagini catalogate scientificamente è stata mia e nasce da una serie di discussioni sull’archivio e sul modo di concepire la fotografia. Io lavoro principalmente nell’editoria periodica, per me l’immagine fotografica è qualcosa di fluido che può vivere in formati e supporti diversi. Nella realtà museale la fotografia esiste principalmente come opera, come oggetto materiale con una specifica forma e formato. In questo esperimento curatoriale questo contrasto era portato inevitabilmente all’estremo. Mi interessava anche il contrasto tra la catalogazione scientifica e tassonomica di un archivio (inevitabilmente ideologico ma con un metodo esplicito e trasparente che possiamo comprendere e criticare) e il modo in cui gli algoritmi o reti neurali catalogano giornalmente le immagini in feed, app, sistemi operativi di smartphone – un metodo opaco, di cui non conosciamo la struttura e per questo potenzialmente problematico quando applicato in situazioni politicamente o socialmente delicate.

SB: CLIP e ChatGPT sono due modelli nati da OpenAI: esiste una relazione concreta tra i due, o si tratta semplicemente di strumenti indipendenti creati dalla stessa “scuola progettuale”?

GM: Si tratta di due strumenti sviluppati dalla stessa azienda.

SB: Nel vostro lavoro con ANIMATI avete scelto di usare CLIP, ma vi siete mai interrogati su cosa potrebbe nascere dall’integrazione tra un modello visivo e uno linguistico, come ChatGPT? Esistono, secondo voi, possibilità pratiche per un uso artistico di questa convergenza?

GM: La risposta a questa domanda è in mostra: ho realizzato un’opera intitolata 67 Days, 364 Hours, 21.840 Minutes, 163.350 Vectors. Si tratta di una collezione di 163.350 immagini generate reimpiegando alcuni dei materiali del museo come filtro estetico per orientare uno dei modelli generativi più recenti. Ciascuna immagine è proiettata in uno slideshow per 8 secondi e il tempo totale della proiezione copre la durata di apertura della mostra. Significa che se qualcuno andasse tutti i giorni dal primo all’ultimo non vedrebbe mai ripetersi la stessa immagine. L’opera, tra le altre cose che fa, solleva molte domande rispetto a temi come il feed dei social media, la storia dell’attenzione, il destino della memoria e della verità.

SB: Il motore che hai sviluppato per interrogare l’archivio con CLIP sembra aprire a modalità di fruizione radicalmente nuove. Credi che un approccio “Google-style” possa cambiare il modo in cui il pubblico e gli artisti si avvicinano alle collezioni museali, anche oltre i limiti imposti dalla storiografia o dalla catalogazione tradizionale?

GM: Il motore è scritto in Python e ha una interfaccia grafica in Html. Mi piacerebbe che questa mostra servisse ad ispirare le istituzioni museali ad aggiornare i propri strumenti di ricerca online. Penso anche ad archivi internazionali come Europeana. Si aprirebbero prospettive inedite e la possibilità di realizzare tagli storiografici o formali capaci di dare nuova vita agli archivi. Con lo strumento che ho sviluppato si potrebbe fare una mostra sui colori: una sala con opere blu, una sala con opere rosse, e così via. Sono percorsi che probabilmente interesserebbero poco gli storici dell’arte convenzionali mentre sono sicuro che pubblico e artisti risponderebbero in maniera molto diversa… Mi sarebbe piaciuto mostrare questo strumento ad Aby Warburg. Io lavoro pensando sempre al motto di Barnett Newman secondo cui l’estetica sta all’arte come l’ornitologia agli uccelli. Vale lo stesso per la storia dell’arte, che sta alle opere così come la chimica sta ai colori o le neuroscienze alle emozioni.

SB: L’identità visiva di ANIMATI sembra funzionare come un’estensione del metodo curatoriale, tra sperimentazione digitale e riflessione sull’oggetto fisico. Come avete pensato e strutturato questa identità, e in che modo guida o disorienta volutamente lo spettatore all’interno della mostra?

Emanuele Amighetti: Come premessa generale sull’identità sicuramente è importante sottolineare che prende forma dai nostri interessi di ricercatori su post-internet society, cultura digitale e ibridazioni tecnologiche applicate in un contesto che invece vive e preserva la matericità dell’opera fotografica. Per questo abbiamo definito tutto come un esperimento e abbiamo lavorato insieme sui vari livelli della mostra. L’identità è uno show off del metodo, la cui completa comprensione può dipendere anche dall’attenzione dello sguardo dello spettatore, un po’ come in un videogame. Nella mostra non ci sono volutamente didascalie. Allestimento e sequenza sono pensati per essere immersivi, per dare un’esperienza visuale diretta. Per conoscere origine e dati di ogni opera, e per interrogarsi sul rapporto immagine-query direi, bisogna guardare ad altri supporti, ad esempio il poster, che è pensato per essere a metà tra utilità e un oggetto d’arte in sé. Questo vale anche per il resto del materiale grafico, è sempre a metà tra uso e opera.

Abbiamo giocato su rapporti binari, bianco e nero, spesso invertiti, usando altri dettagli e colori come elemento di rottura, in parte anche per simboleggiare l’intervento umano nel rapporto con la macchina. Come vedi c’è un processo di svelamento e di contrasti che bisogna approfondire per capire davvero. Durante l’opening abbiamo deciso di stampare dal vivo 150 micro-pubblicazioni di 16 pagine. Ognuna è unica. Le copertine e i retro sono 150, tutti diversi, con immagini tratte dall’installazione di Giacomo. Gli interni invece sono stati sequenziati con AI e composti in modo randomico. Ogni spettatore che ha richiesto la zine possiede una porzione di mostra. Se si unissero tutte le zine con i loro interni, si otterrebbe il catalogo completo con tutte le opere esposte. Ci interessava che uscisse anche il tema dell’unicità, è stato l’unico momento in cui viene davvero spiegato il collegamento effettivo tra query e opera. Abbiamo usato un solo font per tutta la mostra e le sue estensioni. Serve a appianare il processo, come fosse il font di sistema di un supporto digitale.

SB: Hai definito il font scelto come un “font di sistema”, neutro, quasi invisibile. Come si relaziona questa scelta con l’idea di un’intelligenza artificiale che osserva, cataloga e interpreta? È un modo per rendere la macchina leggibile o per metterla in ombra?

EA: Credo che nulla che ha a che fare con la tecnologia possa definirsi neutro, né totalmente invisibile. Ogni cosa che facciamo ha implicazioni e possibili effetti di cui raramente, per lo meno a livello di società allargata, siamo a conoscenza. In questo caso ci piaceva giocare proprio su questa ambiguità, sui contrasti interni. Abbiamo cercato di far nascere la domanda su dove inizia l’intervento umano, il nostro, e dove invece è stata la macchina a produrre contenuti e significati. L’identità serve a far sì che questo sottotesto fosse valido per ogni dettaglio della mostra.

SB: Nel passaggio dal filtraggio algoritmico alla selezione per la mostra fisica, vi siete mai interrogati sulla possibilità di esporre le immagini senza cornici, enfatizzandone l’origine digitale o immateriale? Oppure era chiaro fin dall’inizio che l’obiettivo fosse proprio quello di riaffermare la fotografia come oggetto fisico, con tutto ciò che questo comporta in termini di allestimento e percezione?

CBN: Era importante sia per noi che per il museo che dopo il primo filtraggio algoritmico sulle immagini, in mostra ci fossero opere. La speranza è spingere a una riflessione sullo statuto della fotografia autoriale nell’era dell’intelligenza artificiale, in opposizione alle immagini fotorealistiche generative – direi che è quasi un sottotema della mostra.

SB: Avete introdotto un approccio molto sperimentale all’interno di un’istituzione pubblica. Quali segnali avete colto rispetto alla ricezione di questo metodo da parte del museo, sia a livello di dialogo interno che di visione sul futuro?

CBN: Apertura e interesse. Spero che sia il primo di una lunga serie di esperimenti di questo genere.

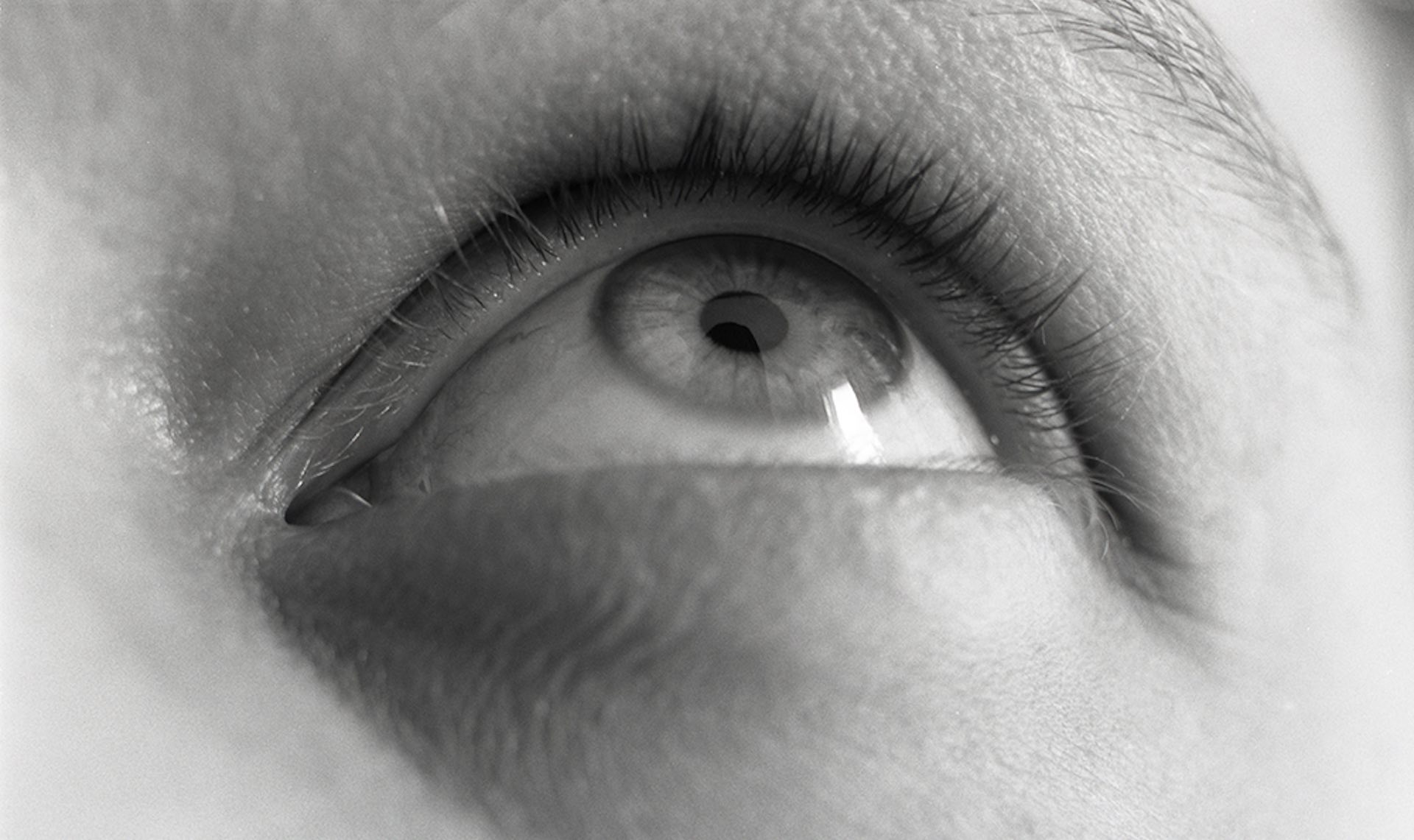

Cover: Giulia Iacolutti, Inscape, 2020© Giulia Iacolutti – Museo di fotografia Contemporanea, Milano-Cinisello Balsamo. Progetto vincitore della Open Call Refocus del MIBACT_DGCC 2020